Ideengeschichte des Privacy by Design – Teil 5: Die Zurückeroberung der Nutzersouveränität

31.10.2016

![]() [IITR – 31.10.16] Dass der transatlantische Versuch, im PETTEP-Projekt (“Privacy Enhancing Technologies Testing and Evaluation Project”) ein gemeinsames Verständnis von „Privacy by Design“ zu entwickeln, scheiterte, war folgenreich. Für Rigo Wenning, der die Diskussion seit Ende der 90er begleitet und heute Rechtsbeistand des W3C ist, war das von Ann Cavoukian propagierte „Privacy by Design“ deshalb zunächst ein „Kampfbegriff ohne Konzept“, da er keinerlei technische Definitionen mit sich verband. Wenning: „Das waren Verhaltensregeln, die beschreiben, wie schön die Welt sein könnte. Aber was es konkret für HTML 5 beispielsweise bedeutete, da gab es keine Antworten.“

[IITR – 31.10.16] Dass der transatlantische Versuch, im PETTEP-Projekt (“Privacy Enhancing Technologies Testing and Evaluation Project”) ein gemeinsames Verständnis von „Privacy by Design“ zu entwickeln, scheiterte, war folgenreich. Für Rigo Wenning, der die Diskussion seit Ende der 90er begleitet und heute Rechtsbeistand des W3C ist, war das von Ann Cavoukian propagierte „Privacy by Design“ deshalb zunächst ein „Kampfbegriff ohne Konzept“, da er keinerlei technische Definitionen mit sich verband. Wenning: „Das waren Verhaltensregeln, die beschreiben, wie schön die Welt sein könnte. Aber was es konkret für HTML 5 beispielsweise bedeutete, da gab es keine Antworten.“

Law is Code

Doch die Antworten sollten nach und nach kommen: Verbindliche „Privacy by Design“-Methoden arbeiten einerseits mit kryptografischen Methoden, andererseits aber auch mit regelbasierten. John Borking verfolgte Ende der 90er Jahre die Grundidee, rechtliche Vorgaben in Softwarecode zu verwandeln. Damals führte der niederländische Datenschutzbeauftragte eine Technikfolgenabschätzung für Software-Agenten durch, die 1999 in das EU-Forschungsprojekt PISA und dem PETS-Handbuch mündete. „Dort wurden zum ersten Mal einfache Privacy-Ontologien entwickelt, die Software-Agenten daraufhin trainierten, nur dann Transaktionen oder einen Informationsaustausch anzustoßen, wenn der kontaktierte Software-Agent dieselben Privacy-Prinzipien verfolgte“, erklärt Borking. Wenn die Prinzipien sich einander nicht entsprachen, durfte der Datentransfer ohne Einwilligung des Nutzers nicht erfolgen. „Ohne diese Privacy-Ontologien, die in Geräten, Maschinen und Telefonen eingebettet werden können, werden wir niemals die Verarbeitung der persönlichen Daten in diesen Geräten schützen können“, sagt Borking.

Auch das W3C griff mit dem von Lorrie Cranor erdachten P3P-Konzept diese Idee auf. Das Konzept basierte darauf, Metadaten zu nutzen, um den Umgang mit den Daten zu regeln. Einen entsprechenden Vorversuch hatte es bereits mit PICS gegeben, einem ebenfalls gescheiterten Jugendschutzstandard des W3C für Website-Inhalte. Der heroische Versuch, Datenschutzpräferenzen im Web technisch durchzusetzen, scheiterte ebenfalls weitgehend.

Die P3P-Techniken haben sich weder in den Browsern, noch in den Webservern durchgesetzt. Microsoft hatte nur eine Schmalspurversion in den Internet Explorer 7 implementiert. Es stellte sich aber heraus, dass Teile des Protokolls für Websites zu komplex waren. Außerdem interessierten sich die amerikanischen Firefox-Entwickler nicht dafür, Regeln zu implementieren, die sie als zu lasch empfanden. Sie setzten auf Cookie-Blocker, die einen sehr viel direkteren Effekt versprachen. Wenning empfindet das heute noch als „bornierten Fundamentalismus“, denn es leitete das heute bekannte Wettrüsten zwischen Ad-Blockern und Websites ein.

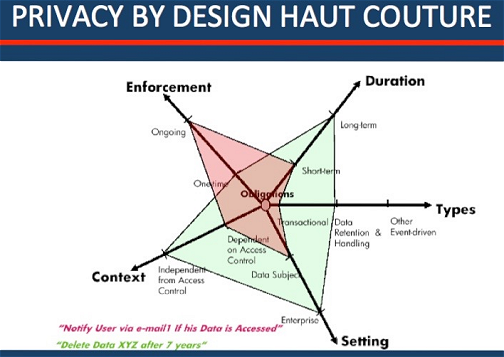

Sticky Policies

Dafür ging es bei den klassischen Computerunternehmen wieder einen Schritt weiter: IBM implementierte mit dem „Tivoli Privacy Manager“ die serverseitigen Teile von P3P und erweiterte sie zu einer in die Websphere-Lösung integrierten Plattform. Michael Waidner – damals IBM Research, heute Leiter des Fraunhofer SIT – entwickelte mit seinem Team 2002 die „Sticky Policies“. Mit dieser Technik soll erreicht werden, dass die Datenschutzpräferenzen in die Daten so eingebettet werden, dass sie unabhängig von ihrem Speicher- und Verarbeitungsort immer nach denselben Datenschutzregeln behandelt werden. Damit konnten anbieterübergreifend Datenströme und Sicherheitsmechanismen regelkonform gesteuert werden.

Trotz der erheblichen Forschungsinvestitionen verkaufte sich IBMs „Tivoli Privacy Manager“ nicht, da es kein im Browser sichtbares Signal gab, das einen besseren Datenschutz angezeigt hätte. Rigo Wenning bekniete IBM eine entsprechende Erweiterung in Mozilla zu finanzieren. Seiner Einschätzung nach hätten 500.000 Euro genügt um den Datenschutz im Browser sichtbar zu machen und damit dem „Tivoli Privacy Manager“ zum Erfolg zu verhelfen. „Denn nur ein sichtbarer Datenschutz wird auch als geschäftlicher Vorteil akzeptiert“, sagt Wenning. Die gleiche Motivation stand auch hinter Helmut Bäumlers Initiative für das Datenschutzgütesiegel – Bäumler war damals übrigens über die Arbeiten an P3P genau informiert, da das ULD Teil der W3C Working Group war.

„Aus der Perspektive der Forschung war P3P ein Meilenstein“, glaubt Wenning. Alle späteren Forschungsarbeiten zum Datenschutz durch Metadatensysteme – das war nämlich die Grundidee hinter PICS, P3P und anderen Systemen – bauten auf dem Konzept auf. Sie ignorierten aber die komplexen Protokolle und verwendeten Metadaten.

PRIME

Mit dem EU-Forschungsprojekt PRIME wurden die Arbeiten 2004 weitergeführt. HP brachte die „Sticky Policies“ in das Projekt ein, das ein wissenschaftlich schlüssiges Konzept zur datenschutzkonformen Datensteuerung inklusive einer Proof-of-Concept-Implementierung vorlegte. Diese Implementierung stellte sich allerdings ebenfalls als wenig praxistauglich heraus. Gleichwohl lag nun eine Bibliothek mit Privacy-Ontologien vor, mit der Datenschutzrecht in Code gegossen werden konnte. Giles Hogben, heute Privacy Engineer bei Google, war im EU-Forschungszentrum in Ispra gemeinsam mit dem STAR Lab der Freien Universität Brüssel federführend verantwortlich.

SAP nahm ebenfalls am PRIME-Projekt teil und entwickelte einen Protoypen. In groß angelegten Installationen hält SAP die „Sticky Policies“ für „sehr vielversprechend“, aber noch immer nicht für einsatzfähig. Zum einen funktionieren die Prototypen nur bei einer geringen Anzahl von Daten und Policen einwandfrei. Zum anderen müssen die Systeme schnell genug sein, um die Policen in Echtzeit bearbeiten zu können. „Der Aufwand steht heute noch nicht in einem vertretbaren Verhältnis zu den Vorteilen der Technologie“, sagt ein Unternehmenssprecher.

Auch HP bewegt sich noch im Forschungsbereich. So gibt es Einsatzkonzepte für den Einsatz in der Cloud und für mobile Geräte. Harald Zwingelberg vom Unabhängigen Landeszentrum für Datenschutz (ULD) sieht wichtige Anwendungsfelder im Bereich von Big und Smart Data: „Den verarbeiteten Daten als Metainformation auch Berechtigungen beizufügen, würde die Rechtssicherheit auch der verantwortlichen Stelle steigern und läge somit sogar im Interesse der Organisationen.“

Für die Internet-Browser gibt es auch noch keine Umsetzung. „Die Europäer müssten nur beherzt 10 Mio. Dollar für europäische Entwickler in die Hand nehmen“, meint Wenning optimistisch,“ damit diese einen europäischen Browsern mit europäischen Werten entwickeln könnten und um eine Wiederholung der Fehler beim „Tivoli Privacy Manager“ zu vermeiden“. Ein solcher Browser hätte dann unter anderem den Vorteil, dass etwa die eIDAS-Verordnung richtig im Web umgesetzt werden könnte.

Marit Hansen warnt allerdings vor allzu viel Euphorie und verweist darauf, dass man mit „Sticky Policies“, „Digital Rights Management“ und „Trusted Platforms“ auch datenschutzfeindliche Policies durchsetzen könne. Deshalb gebe es für diese Instrumente nicht nur Fürsprecher. Hansen: „Hier gilt in besonderem Maße: Es kommt darauf an!“

Do not Track

Ob sich eine Technik durchsetzen kann, ist auch eine Frage der Motivation. Christopher Soghoian beispielsweise schrieb nach einer dreißigminütigen Unterhaltung mit der US-Aufsichtsbehörde FTC ein 30-zeiliges Skript und kreierte damit einen simplen Prototyp des „Do not Track“ (DNT)-Mechanismus. Die ursprüngliche Idee wurde vom W3C aufgegriffen, verfeinert und standardisiert. In den USA ist DNT bisher mäßig erfolgreich, weil die Werbeindustrie eine alternative, technisch schlechtere Lösung verfolgt, die wesentlich weniger Einschränkungen bei der Profilbildung und dem „Targeted Advertisement“ mit sich bringt.

In der EU kann die DNT-Technologie aber noch einen besonderen Status erreichen, wenn sie in den rechtlichen Rahmen eingepasst wird. „Die zuständigen Leute im europäischen Parlament, die an der Datenschutzregulierung arbeiteten, waren jederzeit über die Details der Arbeiten an DNT informiert“ erzählt Wenning. Ziel war es, eine Nutzer-Souveränität herzustellen, ohne den Nutzer zu überfrachten. Denn wenn jede Übertragung personenbezogener Daten mit einem „Ok“ quittiert werden muss, entsteht die berüchtigte „Klickmüdigkeit“: Die Nutzer klicken mechanisch „Ok“ oder verwenden ein Skript, welches das Ok-Signal sendet.

Um das zu verhindern, wurde in Artikel 21, Abs. 5 der Datenschutzgrundverordnung eine Regel eingeführt, die den Widerspruch der Nutzer über einen technischen Mechanismus zulässt. DNT kann ein solcher Mechanismus sein, der die Zustimmung oder die Verweigerung zu einer Datensammlung signalisieren kann, da er die dazu die notwendige technische Schnittstelle definiert. Die hässlichen Cookie-Banner („Wenn sie weiter surfen, sind sie einverstanden“) könnten dann der Vergangenheit angehören.

Privacy by Design als Ultima Ratio

„Es ist nun an der Zeit darüber nachzudenken wie Kontrollmechanismen zugunsten des Nutzers konkret umgesetzt werden können, ohne dabei den Herren der Datenverarbeitung unzumutbare neue Verwaltungsaufgaben abzuverlangen“, meint Wenning. Für ihn ist klar: „Das Datenschutzproblem ist durch die Fortschritte der Datenverarbeitung entstanden und durch das Internet in nie gekanntem Maß skaliert worden. Es ist nun Zeit, dass der Computer auch dem Datensubjekt bei der Verarbeitung seiner eigenen Daten und Präferenzen hilft und komplexe Internet-Vorgänge auf eine verwaltbare Ebene herunterbricht. Denn letztlich ist die informationelle Selbstbestimmung nur noch mit Hilfe des Computers als Gehilfen zu halten.“

Wenn man diese Gelegenheit verpasse, so die Erkenntnis in der DNT Working Group, werde es zur Konfrontation zwischen Anbietern und Nutzern kommen. Wenning: „Es wird ein Wettrüsten der Filter und Anti-Filter geben. Das nutzt aber niemand und wird die wirtschaftliche Nutzung des Netzes beinträchtigen.“ Überdies führe ein Wettrüsten letztlich zu immer perfideren Methoden der Profilbildung, siehe das Beispiel „Fingerprinting“.

Eine rechtliche Lösung für solche Techniken ist aufgrund der fehlenden Rechtsdurchsetzung zweifelhaft. Für die Gestaltung von PETs bedeutet das aber, dass sie „das legale Verhalten positiv sanktionieren und beim Verdacht des unerlaubten Profiling entsprechende Gegenmaßnahmen ergreifen müssen,“, meint Wenning. „Privacy by Design“ stelle damit einen neuen Kommunikationskanal zwischen Website und Nutzer her, der zum Interessenausgleich führen könne.

- Teil 1: Die Hand im Bienenstock

- Teil 2: Brückenbauer zwischen Informatik und Recht

- Teil 3: Entwicklungswege

- Teil 4: Wege in die Gestaltung

- Teil 6: Die Operationalisierung des Datenschutzrechts

- Teil 7: Herausforderungen erkennen und gestalten

Autorin:

Christiane Schulzki-Haddouti

Information bei neuen Entwicklungen im Datenschutz

Tragen Sie sich einfach in unseren Newsletter ein und wir informieren Sie über aktuelle Entwicklungen im Datenschutzrecht.